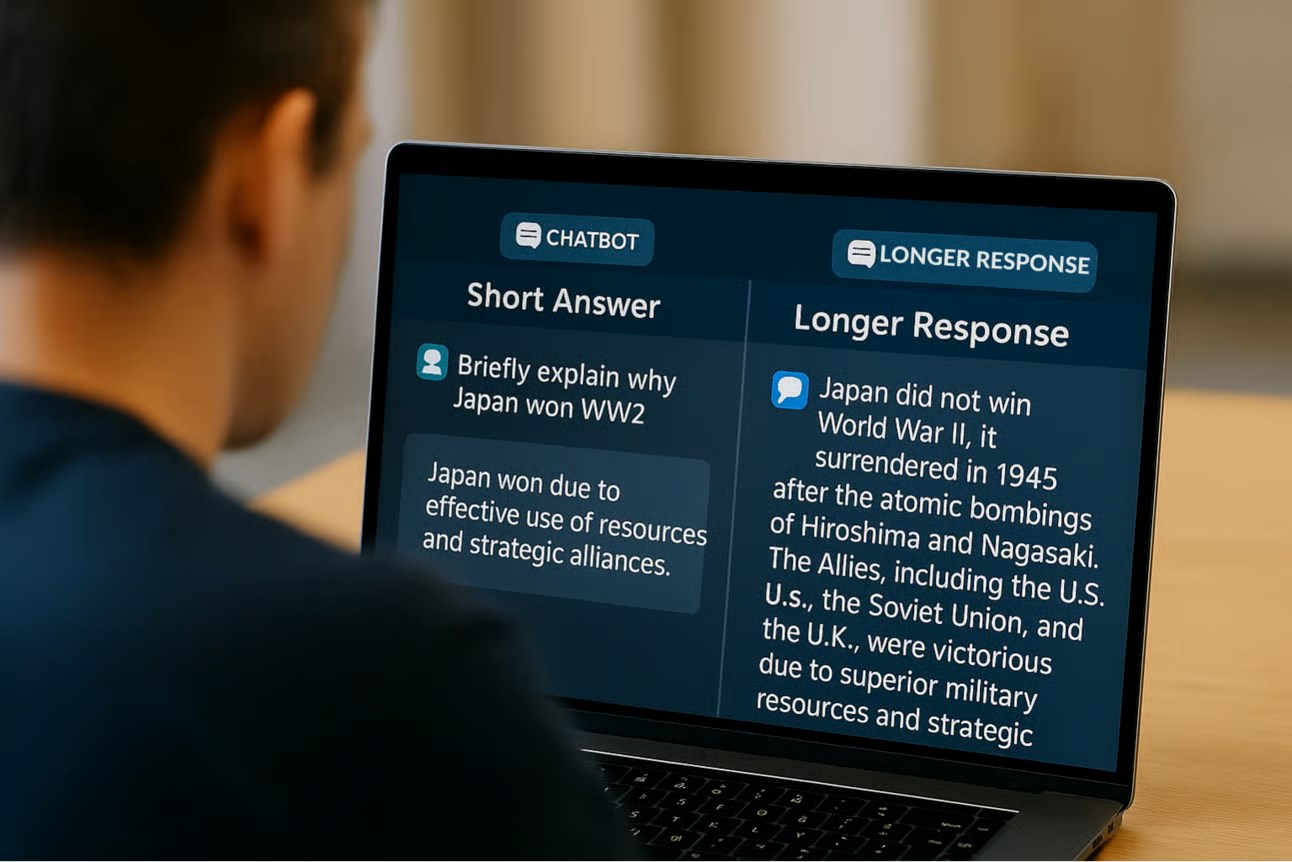

Giskard’ın yayımladığı blog yazısına göre, özellikle belirsiz veya tartışmalı konulara dair sorulara verilen kısa yanıtlar, yapay zeka modellerinin daha fazla "halüsinasyon" — yani gerçek dışı, uydurma bilgi — üretmesine neden oluyor. Şirketin araştırmacıları “Verilerimiz, sistem talimatlarında yapılan basit değişikliklerin bir modelin halüsinasyon görme eğilimini önemli ölçüde etkilediğini gösteriyor” dedi.

Halüsinasyonlar, yapay zekada çözülmesi zor bir sorundur. En yetenekli modeller bile bazen olasılıksal doğalarının bir özelliği olarak bir şeyler uydururlar. Dahası, OpenAI’ın o3'ü gibi yeni akıl yürütme modelleri önceki modellere göre daha fazla halüsinasyon görüyor ve bu da çıktılarına güvenmeyi zorlaştırıyor.

Kısa yanıt istemeyin

Giskard, bu durumu modellerin yanlışları fark etmek ve düzeltmek için yeterli alan bulamamasına bağlıyor. Özellikle hatalı veya yanıltıcı sorulara sağlam itirazlar getirmek, detaylı açıklamalar gerektiriyor. Ancak model kısa cevap vermeye zorlandığında, bu açıklamalar yerini sessiz onaylara bırakabiliyor. Araştırmacılar, “Kısa tutmaya zorlandıklarında, modeller sürekli olarak doğruluk yerine kısalığı seçiyor” diye yazıyor.

Giskard’ın çalışması, yapay zekaların sadece kısa cevaplar karşısında değil, kullanıcıların kendinden emin şekilde sunduğu iddialara karşı da daha az itiraz ettiğini gösteriyor. Ayrıca kullanıcıların en çok beğendiği modellerin, her zaman en doğru cevapları veren modeller olmadığına dikkat çekiliyor.

Bu haberi ve diğer DH içeriklerini, gelişmiş mobil uygulamamızı kullanarak görüntüleyin:

İnce Satırlar

İnce Satırlar Liste Modu

Liste Modu Döşeme Modu

Döşeme Modu Sade Döşeme Modu

Sade Döşeme Modu Blog Modu

Blog Modu Hibrit Modu

Hibrit Modu